Comme nous, vous partez probablement en vacances. Et comme tout le monde, vous dégainez votre smartphone, histoire de capturer tout qui vous entoure. Que l’on gambade sur les plages de Palavas-les-Flots ou que l’on soit en vadrouille dans les Highlands d’Écosse, une simple photographie ne suffit parfois pas à capturer l’immensité des paysages. C’est à ce moment-là qu’on claque un petit panorama à 360 degrés, en tournant sur soi, smartphone en main.

À voir aussi sur Konbini

Sans le savoir, avec cette fonctionnalité qui semble aujourd’hui si évidente, vous utilisez la computational photography. Ce terme un brin barbare n’a pas (encore) d’équivalence en français mais pourrait se traduire par “photographie de calcul” ou “photographie par ordinateur”.

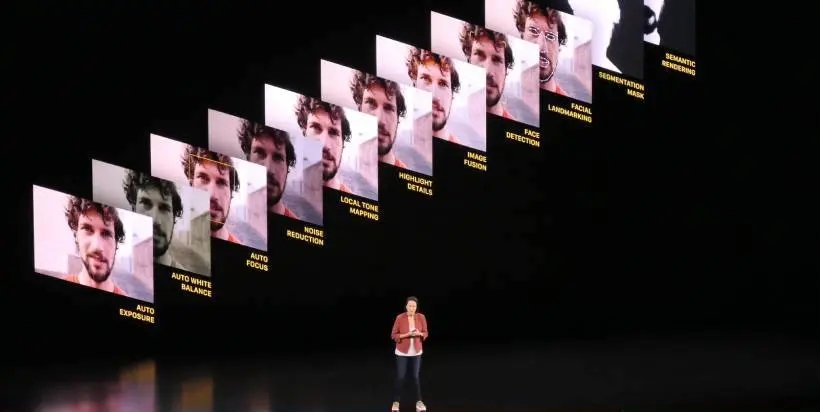

Il recouvre surtout une révolution dans le monde de la photographie : la manière dont les algorithmes, le code informatique et le machine learning augmentent nos images et font peu à peu de nos smartphones des appareils plus puissants que des les appareils photo reflex. Et puisque ces recherches technologiques semblent aussi présentes que méconnues, nous avions envie d’en savoir plus…

C’est quoi la computational photography ?

Le mardi 15 octobre, à New York, Google dévoilait son dernier smartphone, le Pixel 4. “Le hardware n’est pas ce qui rend notre appareil photo bien meilleur, balance sur scène Sabrina Ellis, vice-présidente à la gestion des produits. La potion magique qui rend notre caméra si unique, c’est notre computational photography.”

Le pionnier de cette potion magique s’appelle Marc Levoy. Professeur émérite en science informatique à Stanford et grand manitou de la photographie chez Google, il considère la computational photography comme un ensemble “de techniques qui permettent d’augmenter ou d’étendre les capacités de la photographie numériques”. Au sein de la firme de Mountain View, dans les laboratoires de Google AI, Marc Levoy a constitué une équipe dédiée uniquement à la recherche en computational photography.

“La computational photography, c’est faire de la photographie avec du logiciel plutôt qu’avec des optiques”, nous explique par visioconférence Alexander Schiffhauer, manager produit et spécialiste du mode “Vision de Nuit” sur les téléphones Pixel au sein de cette même équipe. “Si vous souhaitez avoir la même qualité d’image que les professionnels en regardant uniquement du côté du hardware, vous devez avoir un téléphone énorme. C’est impossible, votre smartphone doit tenir dans votre poche. Alors vous devez être plus malin et utiliser le machine learning”, précise-t-il.

Les mains dans les pixels de la photographie augmentée

Prenons un exemple simple : le mode HDR. Trois petites lettres désormais présentes sur la majorité de nos appareils photo qui signifient, en français, ” imagerie à grande gamme dynamique”. Ce mode permet de capturer plusieurs images au même moment, en une poignée de secondes, avec des tonalités et un temps d’exposition différents. Le logiciel de la caméra combine ces images et propose à l’utilisateur·rice une seule et même photographie avec les meilleures propriétés de chaque photographie prise.

L’idée derrière le mode HDR n’est pas nouvelle. Elle vient du bracketing d’exposition, qui consiste à prendre une série d’images successives en déclenchant une seule fois, mais en variant l’ouverture et l’exposition d’un appareil photo. Sauf que sur smartphone, le logiciel permet de prendre, traiter et combiner un ensemble d’images avec différents temps d’exposition pour obtenir une meilleure plage dynamique et un rendu plus fin.

Apple fut le premier fabricant à introduire le mode HDR avec son iPhone 4, en 2010. Depuis, la technologie s’est sophistiquée avec le “Smart HDR” (Apple) ou le “HDR+” (Google). Sur le Pixel 4, Google a même introduit le mode “Live HDR+” qui propose, pour la première fois, de visualiser le rendu du mode HDR sur son écran avant même que la photographie soit prise. Grâce au machine learning, le logiciel analyse les tonalités de lumière captées par la caméra avant que le photographe ait même appuyé sur le déclencheur. Fou, non ?

L’iPhone 11 possède un mode similaire : le “Deep Fusion”, héritier du “Smart HDR”. L’appareil photo prend huit images (quatre en exposition moyenne et quatre en exposition courte) avant que le photographe appuie sur le déclencheur. Une neuvième est prise au moment de shooter et servira de base au rendu final.

La tête dans l’astrophotographie

On peut considérer le fonctionnement du mode HDR – et ses multiples évolutions – comme une base théorique sur laquelle s’appuie la computational photography. L’étonnant mode “astrophotographie” du Pixel 4, basé sur le mode “Night Sight” apparu avec le Pixel 3, est l’une des dernières avancées dans ce champ de recherche. Comment un smartphone peut-il prendre des images nettes des étoiles, quand on sait à quel point il est difficile de les réaliser avec un appareil photo professionnel ?

Avec un reflex numérique classique, il est nécessaire d’ouvrir l’obturateur plus longtemps pour capter un maximum de lumière et, évidemment, de poser l’appareil sur un pied pour un maximum de stabilité. Les capteurs photo du Pixel 4, eux, ne sont pas aussi puissants. Il va donc falloir faire autrement, en choisissant le temps d’exposition parfait, en réalisant plusieurs images pour les faire fusionner et en augmentant la stabilité de l’appareil.

“Les algorithmes fonctionnent continuellement en arrière-plan pour trouver quel est le temps d’exposition le plus long que la caméra peut capturer, tout en analysant le mouvement de l’appareil”, continue Alexander Schieffler. Une photo du ciel étoilé avec le Pixel 4 peut ainsi prendre jusqu’à 4 minutes d’exposition.

Durant ce laps de temps, l’appareil réalisera un maximum de 15 photos, chacune exposées à environ 16 secondes. À partir de là, le logiciel du Pixel 4 va aligner chaque exposition avec l’autre. Une fonction “segmentation sémantique” identifie ensuite les éléments qui composent la photographie pour traiter le bruit et les pixels qui ne conviennent pas, égalisant l’ensemble. Et si vous voulez absolument tout savoir sur l’astrophotographie, c’est par ici.

Un avant et après suppression des “pixels chauds” par l’AI. (© Google)

Dans le futur, les appareils photo dopés à l’intelligence artificielle

La question est de savoir jusqu’où ira la recherche en computational photography ? Après “Deep Fusion” chez Apple, le mode “astrophotographie” chez Google, la super résolution ou les modes 3D, quelles pourraient être les prochaines grandes avancées de la photo sur smartphone ?

“Nous nous intéressons énormément au concept de ‘moment’. Quand vous prenez, disons, une photographie de groupe, vous prenez probablement plusieurs images à la chaîne. J’imagine que vous en prenez trois ou quatre de la même scène. On considère qu’il s’agit d’un échec. Avec le machine learning, nous pouvons être vraiment, vraiment bons pour capturer l’instant le plus authentique et candide. Et même si le photographe ne le voit pas, la caméra, elle, en est capable”, nous explique Isaac Reynolds, manager produit pour le Pixel 4 chez Google AI.

Situation classique : vous prenez une photo, et ça ne va pas du tout parce que la personne a les yeux fermés. Grâce au machine learning, notre appareil pourrait être capable de revenir quelques secondes en arrière pour sélectionner un bref instant où les yeux de votre ami·e étaient ouverts. Un type de technique que proposait déjà iOS 7 et qu’il est possible de réaliser avec certaines applications.

“Si on demande aux gens leurs photographies favorites, ils choisissent très souvent des photos qui peuvent être objectivement horribles. Mais ce qui compte, c’est le sourire ou le regard, l’émotion, le bonheur d’un instant précis. Nous pensons que les smartphones peuvent aider à mieux capturer ces moments spéciaux”, poursuit Reynolds.

À quel moment les photographies ne seront plus une création humaine mais le produit pur et simple d’un système d’intelligence artificielle ? C’est la question que l’on se pose, après avoir étudié de plus près la computational photography.